Googleは米国現地時間11月15日、Search Consoleに新しくrobots.txtレポートの機能が追加されたことを発表しました。従来からあるrobots.txtテスターは廃止となります。併せて英語版のSearch Console Helpのドキュメントも更新されていますので、その辺りも含めてご紹介します。

We're excited to announce the new Search Console robots.txt report, available from the settings page. We're also making relevant info available from the Page indexing report. As part of this update, we're sunsetting the robots.txt tester. Check the updated help center page… pic.twitter.com/IHjgF37ssN

— Google Search Central (@googlesearchc) November 15, 2023

引用)@googlesearchcより和訳

どういうこと?

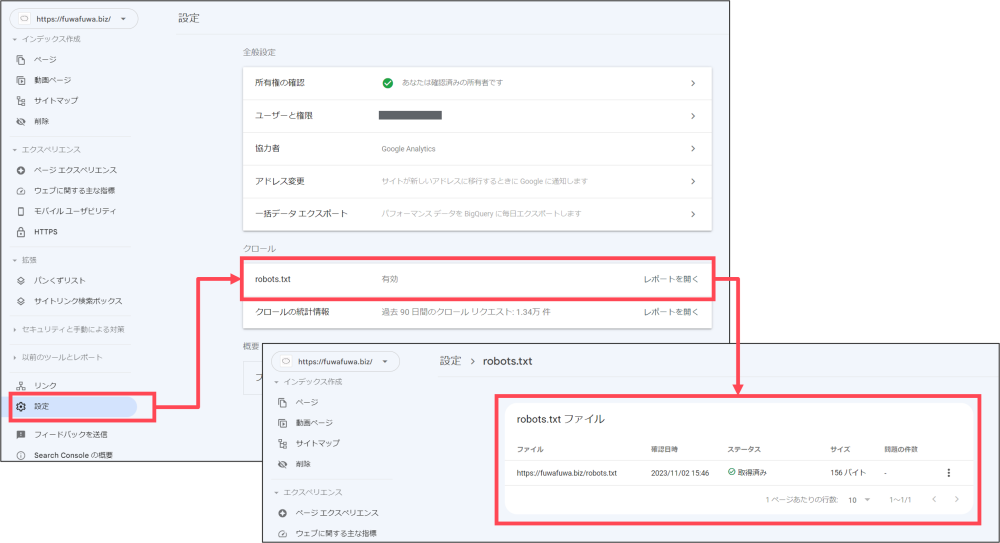

Google Search Consoleのサイドメニューにあった[以前のツールとレポート]項目からrobots.txtテスター機能が無くなり、新しく[設定]から[クロール]の[robots.txt]でGoogleの処理状況や再クロール申請を出来るようになりました。

robots.txtをアップしていれば、こちらの項目から申請やステータス、再クロールが出来るという機能です。この機能が使えるのは、Search Consoleに登録しているのサイトがドメインプロパティ(ルートドメインやサブドメイン)単位やパス(サブディレクトリ展開)の無いURLが対象であって、サブディレクトリ以下で登録しているサイトは対象外とのことです。

- ドメインプロパティ(例:example.com または m.example.com 等)、もしくは

- パスの無いURLプレフィックスプロパティ、例としては https://example.com/ 等が対象で、https://example.com/path/ 等のURLは対象外

引用)Search Central Helpより一部和訳

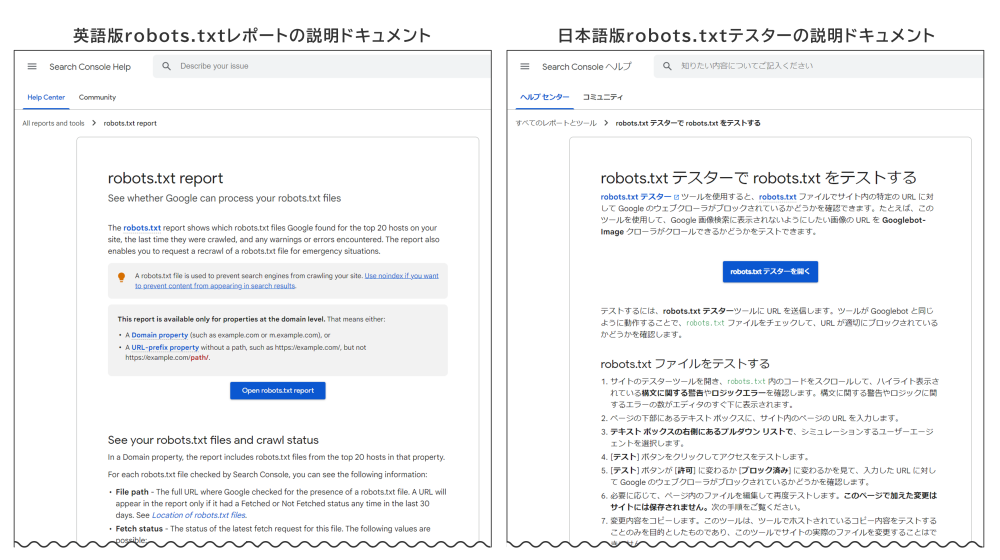

合わせてSearch Consoleにおけるrobots.txtに関する機能ドキュメントも大幅に更新されました。左は新しくなった英語版で、右はまだ古い日本語版です。英語版ではrobots.txtレポートについての説明ドキュメントになっていて、日本語版はrobots.txtテスターについての説明ドキュメントになっています。

robots.txtテスターでは、記述したrobots.txtが正しく機能するかどうかも確認できましたが、そういう機能は無くなってしまいましたね。まぁ、robots.txtをミスる人もいないという前提なのかもしれませんし、間違っていたらインデックスレポートからも確認できるので(robots.txtでブロックしています等)、不要と判断したのかもしれません。とはいえ、結構間違えて記述してしまう人もいるので不安ですね…。

Disallowは慎重に

ちなみに、私が見てきている中で、robots.txtで一番ミスりやすいのは、Disallow:設定です。例えば、example.com/ex1/categoly001/ だけをクロールを制御したいにもかかわらず、Disallow:example.com/ex1/と記述したせいで、example.com/ex1/categoly002/ 等の全てのページURLまでブロックしてしまった等です。この手のミスは結構あちこちで頻繁に起こっているようですのでご注意ください。とはいえ、そういうのも後でSearch Consoleのインデックスレポートで確認できますので、短期的な注意点って感じですかね。

既に普通にrobots.txtを運用している人にはそこまで重要な更新機能ではなかったかもしれませんが、一応ご確認ください。