Googleが米国現地時間9月6日に、検索における25の大きな改革についてThe Keywordにて記事化していたのでご紹介です。2000年頃から検索がどう変化してきたのかについて、25の要素を通して振り返ってくれています。直近のSGEに至るまで、Google検索がどんな変遷を辿ってきたか、息抜きにご覧いただければと思います。

Google検索の推移

Google検索が25歳を迎えたとのことで、Danny Sullivan氏がこれまでの25年間を25個の大きな改革と共に振り返っています。以下和訳をご覧ください。最後にこの流れから考えらえる検索の短期的未来について、私なりの感想も添えておきます。

役立つ画像からAIまで、検索における25の大きな瞬間

Googleが25年の間にどのように検索をより便利なものにしてきたか、ちょっとした面白味と共にご紹介します。

25年前にGoogleがサービスを開始した時、検索エンジンと呼ぶにはほど遠いものでした。しかしすぐにGoogle検索は、人々が探している情報を想像していたよりも早く的確に提供することで知られるようになりました。

長年にわたり私たちは革新を続け、Google検索を日々より良いものにしてきました。まったく新しい検索方法の開発から、リスティングや広告を通じて何百万ものビジネスが顧客とつながるための支援(2001年にAdWordsを通じたローカルビジネスの広告からスタート)、そしてDoodlesやイースターエッグで楽しむことに至るまで、それは大変な道のりでした。

Googleの25歳の誕生日を記念して、重要な瞬間にGoogleをより便利にし、現在のGoogleに大きな役割を果たしたマイルストーンを振り返ります。Googleの歴史については、Search Through Timeをご覧ください。

2001:Google画像検索

2000年のグラミー賞にジェニファー・ロペスが出席した際、彼女の大胆なヴェルサーチのドレスは瞬く間にファッション界の伝説となり、当時Googleで最も人気のあったクエリとなりました。当時、検索結果は青いリンクのリストだけだったので、人々は探している写真を簡単に見つけることができませんでした。このことが、私たちがGoogle画像検索を作るきっかけとなりました。

2001年:“もしかして?”

スペルミスの訂正を提案する“Did you mean(もしかして)”は、機械学習の最初の応用例のひとつでした。以前は、検索結果にスペルミス(“floorescent[蛍光という意味の単語“fluorescent”のスペルミス]”など)があった場合、同じスペルミスのある他のページを探す手助けをしていました。長年にわたり、キーボード上で指が滑っても必要なものを見つけられるよう、AIを駆使した新しいテクニックを開発してきました。

2002:Googleニュース

2001年9月11日の悲劇的な出来事の間、人々はGoogle検索結果上でタイムリーな情報を見つけるのに苦労しました。リアルタイムのニュースに対するニーズに応えるため、翌年、Googleニュースを開始しました。

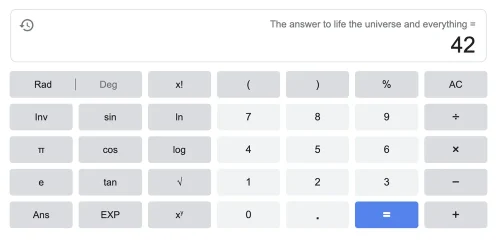

2003:イースターエッグ

Googler(Google社員)は長年にわたり、Google検索に隠された巧妙なイースターエッグを数多く開発してきました。2003年、最初のイースターエッグのひとつが、生命、宇宙、そして万物についての究極の疑問の答えを教えてくれました。それ以来、何百万人もの人々が、ページを斜めに見たり、画面がぐるっと一回転したり、“もしかして”の内容が再帰するループを楽しんだり、ポップカルチャーの瞬間を祝ったりしてきました。

2004:オートコンプリート

あなたが普段考えるのと同じように素早くタイプできたら良いと思いませんか? そんな時はオートコンプリートの出番です。“Googleサジェスト”として最初に登場したこの機能は、入力が始まると自動的に検索バーのクエリを予測します。今日では、オートコンプリートは平均してタイピングを25%削減し、1日あたり推定200年以上のタイピング時間を削減しています。

2004:ローカル情報

かつて人々は、ビジネス情報を従来の電話帳に頼っていました。Webは、“シカゴのピザ”や“ヘアカット 75001(テキサス州の郵便番号、テキサス州でヘアサロンを探すクエリ)”のようなローカルな情報発見への道を開きました。2004年、Googleのローカルガイドは、地図、道順、レビューのようなビジネスリスティングに関連情報を追加しました。2011年には、モバイルでClick-to-Call機能を追加し、外出先から簡単にビジネスにアクセスできるようになりました。Googleのローカル検索結果は、電話や道案内、料理の注文や予約など、毎月平均65億件以上のビジネスに繋がっています。

2006:Google翻訳

Googleの研究者は、オンライン上の言語の障壁に取り組むため、2002年に機械翻訳技術の開発を開始しました。その4年後、アラビア語と英語のテキスト翻訳を提供するGoogle翻訳をローンチしました。現在、Google翻訳は100以上の言語に対応しており、昨年は24の言語が追加されました。

2006:Googleトレンド

Googleトレンドは、集計されたデータを使ってGoogle検索に関するトレンドを把握するために作られました(そして、毎年恒例のYear in Searchを作成しました)。現在、Googleトレンドは、この種の無料データセットとしては世界最大規模を誇り、ジャーナリスト、研究者、学者、ブランドは、検索結果が時間とともにどのように変化するかを知ることができます。

2007:ユニバーサル検索

有益な検索結果には、リンク、画像、動画、ローカル検索結果など、様々な形式の関連情報が含まれるべきです。そこで私たちは、すべてのタイプのコンテンツを一度に検索し、いつ、どこで検索結果を混在させるかを決定し、明確で直感的な方法で検索結果を提供できるようシステムを再設計しました。その結果生まれたユニバーサル検索は、当時、Google検索における最も急進的な変化でした。

2008:Googleモバイルアプリ

AppleのApp Storeの登場に伴い、iPhoneで初のGoogleモバイルアプリをリリースしました。オートコンプリートや“私の地域”などの機能により、少ないキー操作で簡単に検索できるようになり、特に小さな画面サイズ時に役立ちました。今日、AndroidとiOSの両方で利用できるGoogleアプリでは、Googleレンズを使って数学の宿題を手伝ったり、ワンタップで視覚的な翻訳ツールにアクセスしたりと、できることがたくさんあります。

2008:音声検索

2008年、Googleモバイルアプリで音声による検索機能を導入し、2011年にはデスクトップにも拡大しました。音声検索では、ボタンを押すだけで音声による検索が可能です。現在、音声による検索は特にインドで人気で、毎日音声でクエリ入力を行うインド人の割合は世界平均の約2倍となっています。

2009:緊急ホットライン

娘が危険性のあるものを飲み込んでしまい、毒物管理情報を探すのに苦労していたとある母親からの提案を受けて、検索結果ページの上部に毒物管理センターのホットラインのボックスを設けました。この開設以来、私たちは、自殺予防のような緊急時に必要な緊急ホットラインを充実させてきました。

2011:画像による検索

検索しているものを言葉で説明するのが難しい場合があると思います。そこで私たちは画像による検索を開始し、任意の画像や画像のURLをアップロードして、それが何であるか、そしてその画像がWeb上の他のどこにあるかを調べることができるようにしました。このアップデートは、後のGoogleレンズへの道に繋がることとなりました。

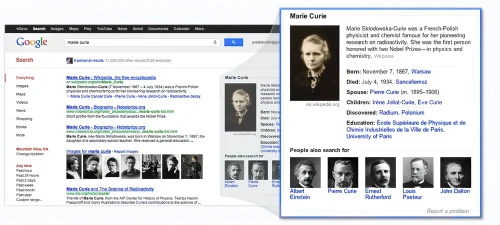

2012:ナレッジグラフ

ナレッジグラフを導入しました。ナレッジグラフは、世界中の人、場所、物事と、それらが互いにどのように関連しているかを示す膨大なコレクションで、迅速な回答を簡単に得ることができます。ナレッジグラフを利用した最初の機能であるナレッジパネルは、有名人、都市、スポーツチームなどのトピックに関する情報を素早く表示します。

2015: 混雑する時間帯

レストラン、店舗、美術館などの場所を検索する際に、1日で最も混雑している時間帯を確認できるよう、Google検索とGoogleマップに混雑する時間帯機能を開始しました。

2016:Google Discover

パーソナライズされたフィード(現在はDiscoverと呼ぶ)を開始することで、検索しなくてもGoogleアプリ内で自分の興味に合わせたコンテンツを探せるようにしました。

2017:Googleレンズ

Googleレンズは、写真内の物体を調べ、他の画像と比較し、元の画像との類似性や関連性に基づいて他の画像をランク付けすることで、カメラを検索クエリに変えます。現在では、Googleアプリであなたが見たものをそのまま検索することができます。現在、Googleレンズでは月間120億回以上ものビジュアル検索が行われています。

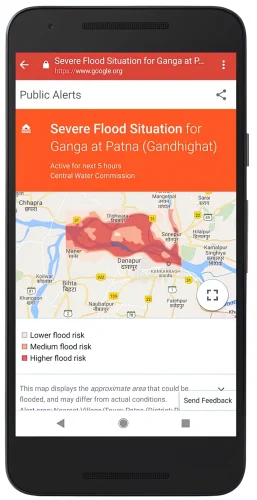

2018:洪水予測

間近に迫った洪水への備えを強化するため、私たちはAIを使って壊滅的な洪水がいつどこで発生するかを予測するモデルを作成しました。この取り組みはインドで始まり、現在では80ヶ国に洪水警報を拡大しています。

2019:BERT

Google検索を有用なものにしている大きな要素は、言語を理解する能力です。2018年、私たちは言語理解モデルを訓練するためのニューラルネットワークベースの技術、BERT(Bidirectional Encoder Representations from Transformers)を導入し、オープンソース化しました。BERTは言語をよりよく理解することで、検索をより役立つものにします。つまり、単語の完全な文脈を考慮するのです。2019年の厳密なテストの後、私たちは70以上の言語にBERTを適用しました。

あなたの検索を理解するためにBERTがどのように機能するかについては、こちらをご覧ください。

2020:ショッピンググラフ

あらゆる小売業者やブランドがGoogleに商品を表示することを無料にしたことで、オンラインショッピングはより簡単で包括的なものになりました。また、常に更新される商品、販売者、ブランド、レビュー、地域の在庫をAIがデータ化したショッピンググラフを導入し、現在では350億件の商品リストが掲載されています。

2020: Hum to Search(鼻歌検索)

GoogleアプリにHum to Search(鼻歌検索)を導入し、頭に残っている曲を思い出せずにイライラすることがなくなりました。この機械学習機能は、鼻歌、口笛、またはメロディーを歌うと、その曲にマッチする可能性のある曲を特定します。そして、その曲とアーティストの情報を調べることができます。

2021:About this result(この検索結果について)

どの検索結果が自分にとって最も有益で信頼できるのか、より多くの情報に基づいた判断ができるよう、ほとんどの検索結果の横に“About this result”機能を追加しました。これは、情報リテラシーの専門家によるベストプラクティスに基づき、検索結果が表示される理由を説明し、コンテンツとその出典に関するより詳細な背景を示すものです。“About this result”は、Google検索が利用できるすべての言語で利用できるようになりました。

2022:マルチサーチ

どんなに難しい情報でも、あなたが探している情報を発見できるように、私たちはマルチサーチを通じて、テキストと画像を同時に検索するまったく新しい方法を開発しました。例えば、ダイニングセットの写真を撮り、“コーヒーテーブル”というクエリを追加して、マッチするテーブルを見つけることができます。マルチサーチは米国で初めてリリースされ、現在ではGoogleレンズが利用可能なすべての言語と国で、世界中のモバイル端末で利用可能です。

2023:Search LabsとSearch Generative Experience(SGE)

Google検索では毎年、何十万もの実験を行い、どうすればGoogleをより役立つものにできるかを考えています。Search Labsでは、初期段階の実験をテストしたり、実験に取り組んでいるチームと直接フィードバックを共有したりできます。最初の実験であるSGEは、ジェネレーティブAIの力を直接Google検索にもたらします。AIを活用した概要や、さらに詳しく調べるためのポインタ、フォローアップを求める自然な方法によって、トピックの要点をつかむことができます。米国でサービスを開始して以来、私たちは急速に新機能を追加しており、今後もさらに追加していく予定です。

20年以上にわたって検索エンジンの世界を見てきた者として、Googleがどのようなところから始まり、そしてここまで来たかを振り返るのは驚くべきことですね。

引用)The Keywordより和訳

はい、Google検索の機能遍歴についてまとめられた記事でした。

こうして振り返って読んでみると、なんとなくあることが分かります。それは、どんどん直感的になっていること、です。それは視覚的要素の最大化であったり入力の効率化であったり、多面的な詳細の最適化が働いていますが、最終的には直感的であることに向かっているように感じます。

検索の未来について考える

直感的であるということを理屈で言うならば“最小限のインプットで適切な情報を最大限に享受すること”ですよね。そのためにわざわざ言葉で入力しなくても、画像をアップロードするだけでGoogle検索に理解させ回答をもらったり、口頭で伝えるだけで回答をもらったり等の機能が充実してきているのだと思います。

そして、検索の更なる進化を私が予測するのであれば、今後もっとGoogle検索が必要になってくるのは“指示代名詞の理解”と“記憶”の2点かな、と。検索する人間側にとって「昨日のアレ」とか「さっきのアレ」とかを伝えるだけで通じるようになり、適切な回答をしてくれるのであればそれはかなり便利になってくるでしょう。これにはGoogle検索はスタンドアローン的で断片的な情報検索よりも、ネットワーク的で継続的な情報検索に向けて強化されることが必要になってくるはずです。そして、これがより便利な検索の未来として考えられる姿と呼べるかもしれません。あとは、個人情報や人間の持つ資産の確保やポリシー、AIが侵害しない境域、等の定義次第ですかね。

いずれにしても、数年先の検索UIは、今では想像もつかないことになっていることでしょう。