GoogleのCEOであるSundar Pichai氏が米国現地時間6月7日、GoogleとしてAI(人工知能)技術等を兵器利用しない旨をGoogleのAI理念として発表しました。

背景として

もともとGoogleはロボットの開発や軍事産業で有名なBoston Dynamics社を2013年に買収しています。Boston Dynamics社は既に軍と契約していたものの、Googleとして新たに国防総省と(軍事)契約するつもりはないと公表していました。

Boston Dynamics社のロボット開発は日本でも有名ですね。実はGoogle傘下の会社なんです。

しかし今年の3月になって、2017年9月にGoogleは自社のAIを使ったドローン(攻撃の)性能向上プロジェクトにおいて、国防総省と契約していたことが分かりました。

- グーグルは、AIとドローンについて、国防総省と契約を結んでいることを認めた。だが詳細は明らかにしていない。

- 同社は技術は「非攻撃的」な目的に使われていると語った。

- グーグルは長年にわたって軍事産業にかかわることを避けてきた。これは非公式な企業方針と思われてきた。

- 国防総省に協力しているというニュースは、多くの従業員を動揺させているようだ。

それによって、Googleは社外だけではなく社内からも抗議や退職者が殺到していましたが、先週(米国現地時間6月1日)に、Googleはその契約を2019年3月をもって契約更新しないと発表しました。

引用)CNN.co.jp

しかし、まだまだGoogleと国防総省との間で様々な契約があるのではないかと世間では言われており、不信感も拭えない中での今回のCEO発表となったわけです。

Sundar Pichai氏のブログ内容

Googleの最高責任者は以下のように述べています。

また、自社製品を越えて、緊急問題への取り組み支援のためにもAIを活用しています。一部の学生は山火事の危険性を予測するために、AIセンサーを製作しています。一部の農家では、家畜の健康モニタリングのためにAI活用しています。医療界ではがん検診時、症状が出る前に未然に防止すべくAI導入を始めています。これらの明確な利益のために、GoogleはAIの研究開発及びそのツール開発を行い、オープンソース・コードでの他者利用も促進できるよう邁進しています。

一方で、確かにそのような強力なテクノロジーが、使い方次第で両刃の剣になることも理解しています。AIが開発され、利用されることは今後長きに渡って、社会に重要な変化と影響をもたらすでしょう。ですので、AI分野におけるリーダーとして、我々には強い責任があると感じています。そこで今日、我々は正しい業務を導くべく、7つの理念を発表します。

Beyond our products, we’re using AI to help people tackle urgent problems. A pair of high school students are building AI-powered sensors to predict the risk of wildfires. Farmers are using it to monitor the health of their herds. Doctors are starting to use AI to help diagnose cancer and prevent blindness. These clear benefits are why Google invests heavily in AI research and development, and makes AI technologies widely available to others via our tools and open-source code.

We recognize that such powerful technology raises equally powerful questions about its use. How AI is developed and used will have a significant impact on society for many years to come. As a leader in AI, we feel a deep responsibility to get this right. So today, we’re announcing seven principles to guide our work going forward.

引用)AI at Google: our principlesより意訳

7つの主義に関しては、以下の内容です。これらはただの形骸化した概念ではなく、具体的なアプローチとして機能させるとも言っています。

2. AIによる不当な偏見や助長を避けること

3. AIは安全に構築とテストを行うこと

4. 公に対して説明責任を持つこと

5. 個人情報保護を徹底すること

6. 科学的レベルの高水準を守ること

7. 以上の主義に合致した用途のみに使用すること

2. Avoid creating or reinforcing unfair bias.

3. Be built and tested for safety.

4. Be accountable to people.

5. Incorporate privacy design principles.

6. Uphold high standards of scientific excellence.

7. Be made available for uses that accord with these principles.

引用)AI at Google: our principlesより意訳

さらに加えて以下も述べています。

1.広く危害を引き起こしたり、危害を引き起こす恐れのある技術。具体的な危険性があり、利益よりも危険性が大幅に上回ると判断される場合、我々は適切な安全措置を取ります。

2.主要目的やその実施が人々を危険にさらしたり、危険に繋がる兵器やその他技術。

3.国際的に定められた基準を違反しての情報収集をする技術。

4.目的が国際的な法や人権の尊重に違反するような技術。

1.Technologies that cause or are likely to cause overall harm. Where there is a material risk of harm, we will proceed only where we believe that the benefits substantially outweigh the risks, and will incorporate appropriate safety constraints.

2.Weapons or other technologies whose principal purpose or implementation is to cause or directly facilitate injury to people.

3.Technologies that gather or use information for surveillance violating internationally accepted norms.

4.Technologies whose purpose contravenes widely accepted principles of international law and human rights.

引用)AI at Google: our principlesより意訳

まぁ…人道的見解に基づいて、人々を危険にさらしたり、その恐れのあるものを開発していかない、という話です。どうしてもキレイゴト感は拭えませんが、ドローン軍事協力の契約を更新しない方針というも相俟って、多少の説得力は感じます。しかし、まだまだ国防総省とのパイプラインは継続していくわけですので、何とも言えませんね。

引用)CNET Japan

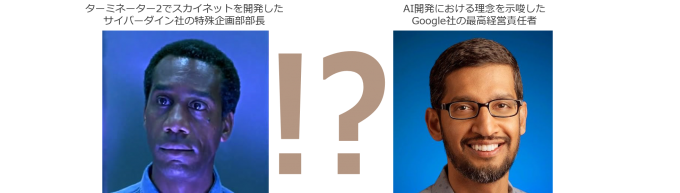

ターミネーター2と被る

やはりこの手の話はついついターミネーター2の中でスカイネット(ほぼAI)を開発したサイバーダイン社と被ります(笑)。サイバーダイン社の開発部長も劇中で「人類を貶めるつもりはなかった…ただただ豊かになることを…」みたいなことを言っていたかと思いますので、どうも余計にオーバーラップしちゃうんですよね…。

【画像引用①】http://www.terminator-mania.net/character/miles_dyson.html

【画像引用②】https://gadgets.ndtv.com/internet/features/who-is-sundar-pichai-the-new-chief-of-google-726264

いずれにしましても、私はGoogleの健全な経営姿勢を支持していますし、世論に流されず自分なりに解釈していきたいと思います。

今のところは――。

皆さんはこの発表を受けて、どう思われますでしょうか。